本篇文章给各位网友带来的资讯是:集成 2.6 万亿个 7nm 晶体管,世界最大 AI 芯片打破单设备训练大模型记录 详情请欣赏下文

以造出世界上最大加速器芯片 CS-2 Wafer Scale Engine 闻名的公司 Cerebras 昨日宣布他们已经在利用“巨芯”进行人工智能训练上走出了重要的一步。该公司训练出了单芯片上全世界最大的 NLP(自然语言处理)AI 模型。

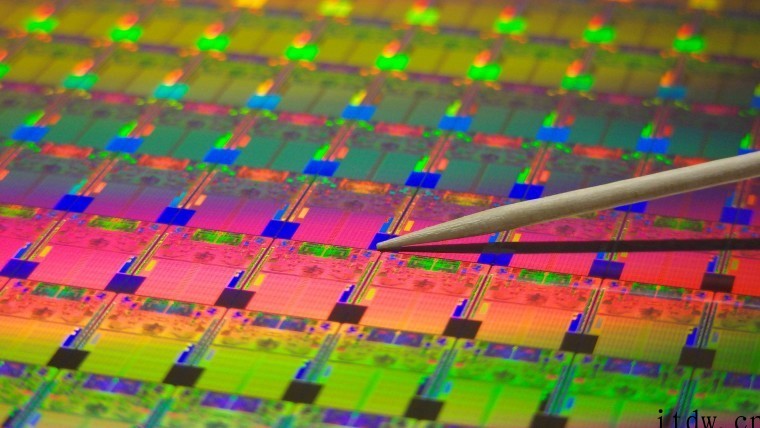

该模型具有 20 亿个参数,基于 CS-2 芯片进行训练。这块全世界最大的加速器芯片采用 7nm 制程工艺,由一整块方形的晶圆刻蚀而成。它的大小数百倍于主流芯片,具有 15KW 的功率。它集成了 2.6 万亿个 7nm 晶体管,封装了 850000 个内核和 40GB 内存。

▲ 图:AI 接收信息后生成的“牛油果形状扶手椅”图片

不止于此,该模型还能够使 AI 理解物种、几何、历史时代等复杂的知识。

但要实现这一切并不容易,NLP 模型的传统开发具有极高的算力成本和技术门槛。

实际上,如果只讨论数字,Cerebras 开发的这一模型 20 亿的参数量在同行的衬托下,显得有些平平无奇。

前面提到的 DALL.E 模型具有 120 亿个参数,而目前最大的模型是 DeepMind 于去年年底推出的 Gopher,具有 2800 亿个参数。

但除去惊人的数字外,Cerebras 开发的 NLP 还有一个巨大的突破:它降低了 NLP 模型的开发难度。

「巨芯」如何打败 GPU?

按照传统流程,开发 NLP 模型需要开发者将巨大的 NLP 模型切分若干个功能部分,并将他们的工作负载分散到成百上千个图形处理单元上。

数以千百计的图形处理单元对厂商来说意味着巨大的成本。

技术上的困难也同样使厂商们痛苦不堪。

切分模型是一个定制的问题,每个神经网络、每个 GPU 的规格、以及将他们连接(或互联)在一起的网络都是独一无二的,并且不能跨系统移植。

厂商必须在第一次训练前将这些因素统统考虑清楚。

这项工作极其复杂,有时候甚至需要几个月的时间才能完成。

Cerebras 表示这是 NLP 模型训练中“最痛苦的方面之一”。只有极少数公司拥有开发 NLP 所必要的资源和专业知识。对于人工智能行业中的其他公司而言,NLP 的训练则太昂贵、太耗时且无法使用。

但如果单个芯片就能够支持 20 亿个参数的模型,就意味着不需要使用海量的 GPU 分散训练模型的工作量。这可以为厂商节省数千个 GPU 的训练成本和相关的硬件、扩展要求。同时这也使厂商不必经历切分模型并将其工作负载分配给数千个 GPU 的痛苦。

Cerebras 也并未仅仅执拗于数字,评价一个模型的好坏,参数的数量并不是唯一标准。

比起希望诞生于“巨芯”上的模型“努力”,Cerebras 更希望的是模型“聪明”。

之所以 Cerebras 能够在参数量上取得爆炸式增长,是因为利用了权重流技术。这项技术可以将计算和内存的占用量解耦,并允许将内存扩展到足以存储 AI 工作负载中增加的任何数量的参数。

由于这项突破,设置模型的时间从几个月减少到了几分钟。并且开发者在 GPT-J 和 GPT-Neo 等型号之间“只需几次按键”就可以完成切换。这让 NLP 的开发变得更加简单。

这使得 NLP 领域出现了新的变化。

正如 Intersect360 Research 首席研究官 Dan Olds 对 Cerebras 取得成就的评价:“Cerebras 能够以具有成本效益、易于访问的方式将大型语言模型带给大众,这为人工智能开辟了一个激动人心的新时代。”

1、IT大王遵守相关法律法规,由于本站资源全部来源于网络程序/投稿,故资源量太大无法一一准确核实资源侵权的真实性;

2、出于传递信息之目的,故IT大王可能会误刊发损害或影响您的合法权益,请您积极与我们联系处理(所有内容不代表本站观点与立场);

3、因时间、精力有限,我们无法一一核实每一条消息的真实性,但我们会在发布之前尽最大努力来核实这些信息;

4、无论出于何种目的要求本站删除内容,您均需要提供根据国家版权局发布的示范格式

《要求删除或断开链接侵权网络内容的通知》:https://itdw.cn/ziliao/sfgs.pdf,

国家知识产权局《要求删除或断开链接侵权网络内容的通知》填写说明: http://www.ncac.gov.cn/chinacopyright/contents/12227/342400.shtml

未按照国家知识产权局格式通知一律不予处理;请按照此通知格式填写发至本站的邮箱 wl6@163.com