本篇文章给各位网友带来的资讯是:用“对抗生成网络”也可以 P 图,效果不输 Photoshop 详情请欣赏下文

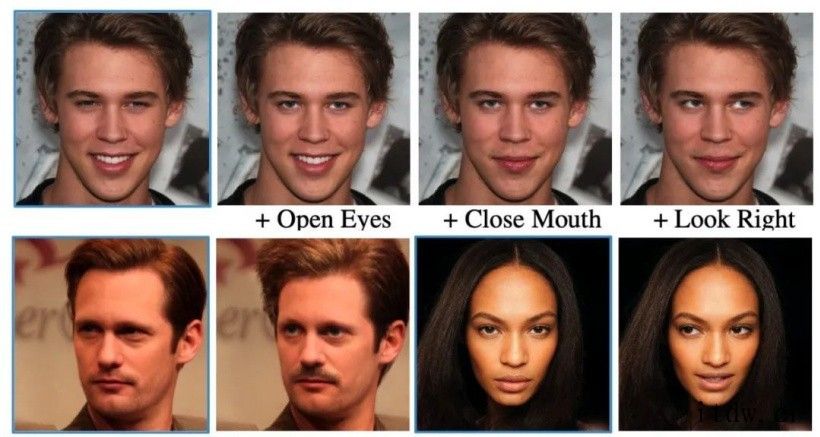

把人的眼睛变大、把嘴合上、转动眼珠:

质量如此逼真、一点糊图的痕迹都没出现 。

如果我不说,你知道这其实是对抗生成网络(Generative Adversarial Network,以下简称为 GAN)自己 P 的吗?

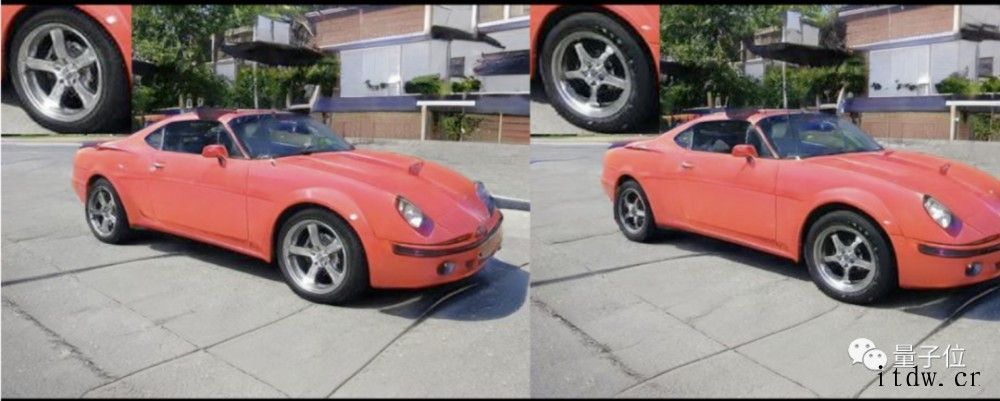

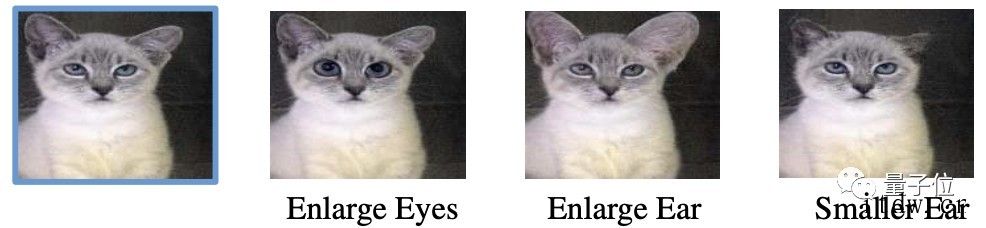

除了人脸,汽车啊鸟啊猫啊也都可以,比如改改车轮大小、换个车轴样式:

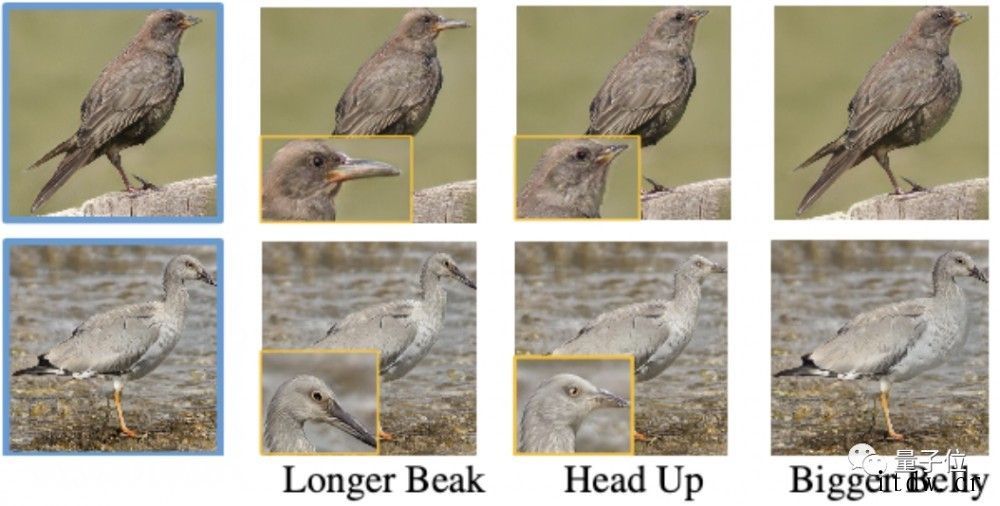

把小鸟的喙部变长、头抬高、胸脯变壮:

用动图展示就更炫酷了:

大点大点,圆点圆点,头发再多一点……

怎么样,这 GAN 的效果是不是也不输 PS?

一个高质量 P 图 GAN

以上这些都来自一个叫做 EditGAN 的模型,可以对图像实现很多细节上的编辑,同时还能保持原图质量。

研究出自英伟达、多伦多大学以及 MIT,相关论文已被 NeurIPS 2021 接收。

在此之前,大多数基于 GAN 的图像编辑方法往往都需要大规模数据集上的语义分割注释才能训练,并且也只能做一些有限的修改,有的甚至只是在两张图之间简单地进行插值。

EditGAN 作为一种全新方法,只需少量语义标记就能训练。

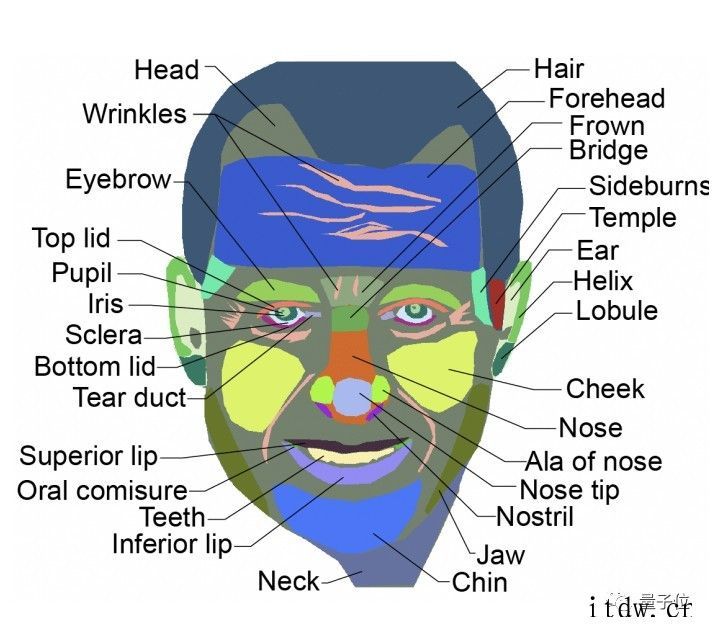

它会把原图像分割成高度精细的语义块(segmentation mask),有多精细呢?

就比如下面这张人脸图,被足足按 30 种语义进行了分割:

而在一个交互工具中(还未开放地址),只需操作这些语义块就可以对相应部分进行修改。

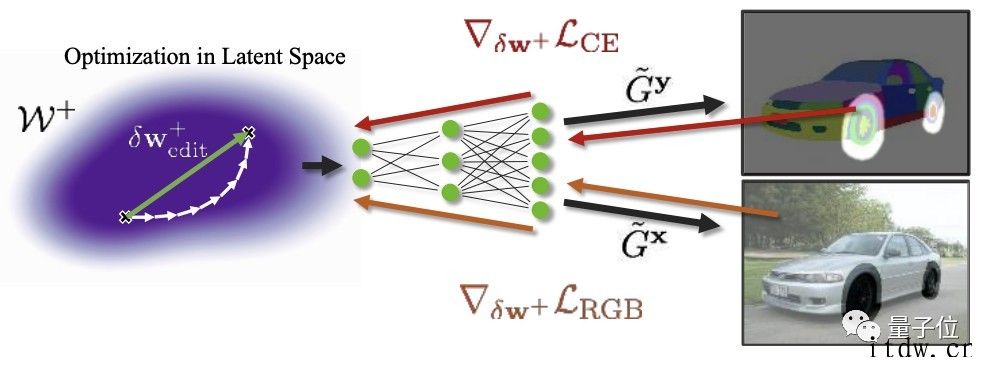

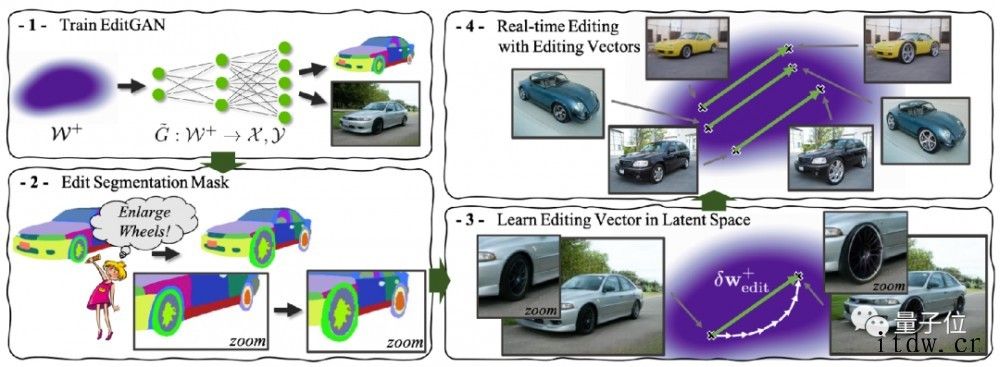

EditGAN 的关键思想在于利用图像和语义分割的联合分布 p (x, y) 。

具体来说就是给定要编辑的新图像 x,将其嵌入到 EditGAN 的潜空间,由于语义分割图和 RGB 图像共享相同的潜码,所以可以得到相应的分割图 y。

接着,使用简单的交互式数字绘画或标签工具,可以根据所需的编辑手动修改分割图 y。

然后进行共享潜码的优化,以保持新分割图与真实图像的 RGB 外观一致,如图所示:

相应的梯度则通过共享生成器反向传播而成。

结果就是潜空间中的编辑向量 δw + edit。

此外,EditGAN 通过学习提炼各种各样的编辑向量,可以直接应用于新的图像。

还可以泛化到绘画作品上

真实质量如何?

研究人员在在四个不同类别的图像上对 EditGAN 进行评估:汽车(空间分辨率 384×512)、鸟类(512×512)、猫(256×256)和人脸(1024×1024)。

-

定性实验结果

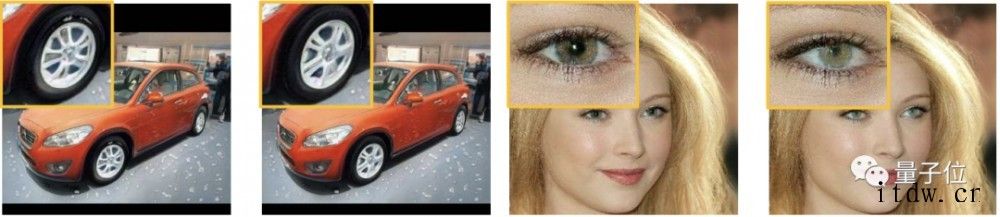

将 EditGAN 此前学习的编辑向量应用于新图像,经过 30 个优化步骤的细化,EditGAN 的编辑操作保持了原图像的质量。

用它进行高精度细节编辑的效果也很好,比如下面左图对轮轴的旋转,右图对瞳孔大小的修改:

在下面这种高清的图像上效果就更好了:

作者表示,目前其他方法都还不能达到这样的效果。

此外,EditGAN 也有很强的泛化能力,比如在下面这种绘画等风格的人像上,做点小表情毫无违和感。

-

定量实验结果

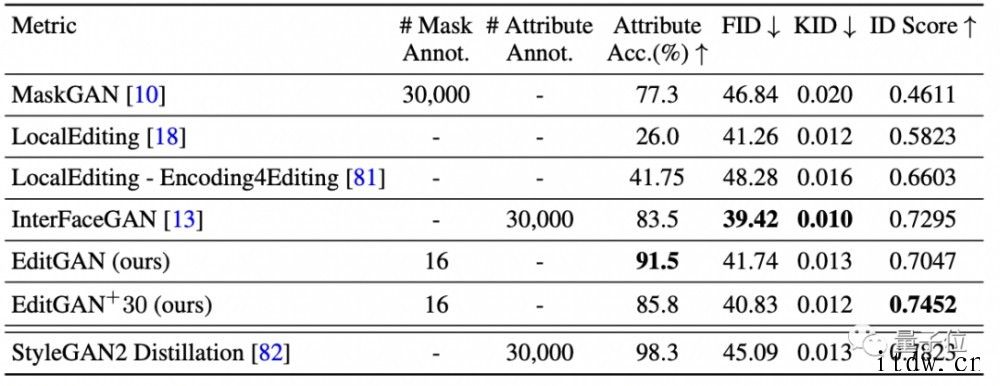

和基于 MaskGAN 的 smile 编辑基准的模型相比,EditGAN 则实现了最佳属性精度和 ID 分数。

最后,和所有基于 GAN 的图像编辑方法一样,EditGAN 仅限于应用到由 GAN 建模的图像上。

作者介绍

一作凌欢,多伦多大学博士生,同时在该校人工智能研究院(Vector Institute)和英伟达做研究。

共同一作 Karsten Kreis,英伟达高级研究科学家,2018 年以博士学位毕业德国马普高分子所。

其余作者包括:英伟达多伦多 AI Lab 的 Li Daiqing,多伦多大学的 Seung Wook Kim,以及 MIT 教授 Antonio Torralba。

通讯作者为一作导师,多伦多大学副教授,英伟达 AI 总监 Sanja Fidler。

1、IT大王遵守相关法律法规,由于本站资源全部来源于网络程序/投稿,故资源量太大无法一一准确核实资源侵权的真实性;

2、出于传递信息之目的,故IT大王可能会误刊发损害或影响您的合法权益,请您积极与我们联系处理(所有内容不代表本站观点与立场);

3、因时间、精力有限,我们无法一一核实每一条消息的真实性,但我们会在发布之前尽最大努力来核实这些信息;

4、无论出于何种目的要求本站删除内容,您均需要提供根据国家版权局发布的示范格式

《要求删除或断开链接侵权网络内容的通知》:https://itdw.cn/ziliao/sfgs.pdf,

国家知识产权局《要求删除或断开链接侵权网络内容的通知》填写说明: http://www.ncac.gov.cn/chinacopyright/contents/12227/342400.shtml

未按照国家知识产权局格式通知一律不予处理;请按照此通知格式填写发至本站的邮箱 wl6@163.com